算力界的罗密欧与朱丽叶:Grok-4-fast和算法的那点事儿

最近这Grok-4-fast可不得了*,就像吃了火箭燃料一样咻咻咻的,把那位”路由器”护体的GPT5都给秒成了渣渣。要知道这可不是一般的厉害,简直是把”我是速度王者”写在了脑门上。吃瓜群众们的第一反应*自然是:“来来来,快翻翻英伟达的供货单”“我赌5毛钱肯定是老黄又偷偷塞了新显卡”“难道是把整栋楼的3090都排排坐焊在了一起?”但这回的故事走向出乎意料——人家最厉害的武器不是硬件,而是一堆烧脑的数学公式*!(此处应有眼镜掉地的音效)据说这群天才工程师们把英伟达论文里的算法黑科技拿来当魔法素材,一顿操作后竟捣鼓出了堪比”光速聊天”的推理性能。这下可好:

隔壁程序员们纷纷开始对着论文膜拜GPU们表示自己被冷落了很委屈马斯克大概正在办公室里跳尬舞庆祝最搞笑的画面*是:NVIDIA那边的人看着自家论文的应用效果,一边拍大腿一边心疼那些没来得及申请的专利费用…本文完全出于娱乐性质写成,不代表任何官方立场。不过说真的,下次谁再说”算法没用”,就把这篇甩TA脸上。*让LLM快53倍的火箭发动机

英伟达的”喷射战士”模型,这回是真的快得飞起!

长期以来,AI推理就像是在等一颗老式台式机开机——成本高、速度慢,让人抓狂。但英伟达这次可没打算束手就擒,直接甩出了他们的新武器——Jet-Nemotron!(听起来是不是像某种赛博朋克超跑的名字?)

关键数据

速度快到离谱:比同行快了整整53倍!你没看错,不是53%,而是53倍!这时候还在用蜗牛爬行的模型们,脸都绿了吧?和巨头掰手腕照样不虚:Gemma3?Llama3.2?Qwen3?统统不在话下!Jet-Nemotron-2B表示:“我不是针对谁,在座的各位都是弟弟。”不是单纯的”堆料怪兽”:这回不靠傻大粗的硬件堆砌,而是玩起了混合结构——就像用乐高搭出火箭,不仅性能猛,还很节约成本!为啥这么牛?

跳出暴力堆参数的怪圈:再堆下去账单怕是比《阿凡达3》的特效预算还夸张了。优化推理效率:就像是把一辆老爷车改装成火箭引擎,瞬间起飞!开源界颤抖:”等比例放大”不再是唯一解法,现在是“又快又猛还便宜”的时代了!英伟达这次算是给行业扔了个AI界的”超级火箭炮”,接下来的模型厂商们如果不赶紧升级玩法,就只能眼睁睁看着用户集体高喊:“Jet-Nemotron,救救我!”

Jet-Nemotron-2B:让AI跑步前进的小个子大能量

在AI界的百米飞人大战MMLU-Pro上,Jet-Nemotron-2B这位“轻量级拳王”不仅一拳KO了Qwen3-1.7B-Base(准确率碾压!),还顺便打破了短跑记录——生成速度快了整整47倍!没错,47倍——基本相当于骑自行车和开宇宙飞船的区别。

更夸张的是,这位2B小朋友(参数意义上的)居然敢跟大块头叫板:MMLU和MMLU-Pro战场上,它不仅硬刚DeepSeek-V3-Small,还一脚踩过了15B参数大佬Moonlight(人家激活参数好歹2.2B呢)。

秘密武器:PortNAS,AI界的乐高大师

凭什么小个子能逆袭?因为它有个叫PortNAS的装修队,专搞“精装房改造”!

传统AI训练*:从零开始盖楼,搬砖搬到手抽筋预算爆炸,工期感人PortNAS方案*:拎包入住:直接拎来一个预训练好的“全注意力毛坯房”冻结MLP工资:告诉MLP(多层感知机):“您老歇着,工资照发,别瞎动!”专注搞装修:所有精力砸向注意力机制改造全注意力层怎么摆?选哪个线性注意力模块最香?能不能DIY个更牛的模块?最后还要让硬件大爷点头:“这房子跑得快吗?”结果?训练成本直接掉进下水道,省下的钱全拿来探索结构,效果自然炸裂——毕竟,谁不喜欢一个又便宜又暴力的AI呢?

全注意力层放置

注意力太贵,英伟达教你”省钱版”注意力

在AI的世界里,”注意力”可不像人的注意力这么便宜——算力可是要花钱的!大多数团队像个土豪一样在所有层里全铺满注意力机制,但英伟达的工程师们表示:”这样花钱太心疼了!”

豪华版 vs 经济适用版

土豪做法:把全注意力机制铺满整个模型,仿佛在说”咱不差钱”聪明做法:保留关键的几个”注意力核心区”,其他改用”简装版”这不是在装修房子,而是在设计AI模型!关键在于保留关键任务处理能力的同时,把不必要的浪费砍掉。

PostNAS的省钱三部曲

先设计个”超级综合体”:既包含”豪宅区”(全注意力),也有”经济适用区”(简配版)培养”学生网络”:让小学生也能学着大学生的样子做题(特征蒸馏)精打细算找最优解:用beam search这个”计算器”找最划算的方案结果?花小钱办大事——保留一点”全注意力奢侈品”,其他改用”平价替代”,效果居然差不多!这年头,连AI都要学理财了…

神经网络界的”偷懒法则”

谁说注意力层都得爱岗敬业?最新研究发现,这帮”注意力层员工”其实比职场老油条还擅长摸鱼——只要少数几个关键层加班加点,其他全在工位上刷短视频,模型照样能交出一份不错的答卷!

实验数据大爆料

PostNAS(挑人的精明主管):只留2层全神贯注干活,准确率就能飙到49%,比部门全员开会还高效。均匀放置(平均主义的HR):逼着所有层一起007,结果准确率惨跌到40%,堪称”吃力不讨好”典范。结论:AI界的二八定律*诚不我欺——20%的关键层贡献80%的效果,剩下80%的层可能只是在假装敲键盘!(老板震怒)选择最优的线性注意力模块

英伟达的大脑健身课:寻找最强的”注意力猛男”

这帮科技狂人最近在硅谷开了一场别开生面的”注意力奥林匹克”,让我们来看看这场高端版的”大力水手”选拔赛:

开场热身 – 英伟达的研究员们首先打了个漂亮的”全注意力”热身操,确认这套基础动作达标后…疯狂举铁 – 他们开始在实验室里疯狂测试各种”注意力健身器材”,试图找出最能打的”肌肉模块”参赛选手:RWKV7:像个少林扫地僧,默默无闻但内功深厚RetNet:自称”记忆大师”,整天吹嘘自己能记住前天晚饭吃的啥Mamba2:这不是那条蛇吗?怎么改行搞技术了GLA:听起来像是某种维生素补剂DeltaNet:三角洲特种部队退役?出手稳准狠Gated DeltaNet:上面那位加了智能门禁的豪华版这场科技界的”健美大赛”正在如火如荼进行中,裁判员们拿着秒表和记分牌,等待着新一代”注意力先生”的诞生!

Gated DeltaNet:当记忆力遇上选择性遗忘

在众多模型里,Gated DeltaNet就像那个考试总是满分的学生,让人既佩服又嫉妒。它的”高分数”可不是天上掉下来的,全靠两项”独门秘籍”:

数据依赖门控机制(简称:路由器的大脑)这玩意儿就像一个极度挑剔的吃货看到新信息就纠结:”这块蛋糕是吃掉呢?还是留着肚子吃后面的寿司?”最终总能做出让所有任务都满意的选择Delta规则(又名:懒人更新大法)普通模型:”我要把整个硬盘格式化了重新写!”Gated DeltaNet:”改几个字不就行了吗?”结果既省内存又不会忘掉前女友的名字(虽然这可能不是好事)通过这种”选择性健忘”的设计,它成功做到了:

减少像松鼠囤坚果一样的重复存储保持记忆的连续性,不会把昨天的事记成上古传说最终在准确率排行榜上笑得像个200斤的孩子更优解:JetBlock

英伟达的新玩具:JetBlock,比Gated DeltaNet还要狂!

你以为英伟达搞出Gated DeltaNet就满足了?不不不,这帮工程师估计是喝了太多黑咖啡,直接搓出了一个更猛的家伙——JetBlock!

为什么JetBlock这么特别?

原来在注意力机制的世界里,卷积一直是那个默默无闻的配角。大多数线性注意力模块用的都是死板的老式卷积核(没错,就是那些“我爱咋算咋算,才不管你输入是啥”的强硬派)。

于是JetBlock登场了,它大喊一声:“我们不能这样过下去了!”然后——

搬出了一个动态卷积核生成器,让它可以根据输入特征现场定制卷积核!效果就是,JetBlock不仅聪明绝顶(根据数据自适应),而且跑得飞快(因为还是线性复杂度!)。简单总结就是:“以前的卷积是食堂阿姨打菜,手一点都不抖;现在的JetBlock是你妈在家做饭,看你想吃啥口味现调!”

没错,英伟达又在AI界掀起了新一轮的“卷”……这次是真的动态开卷!

科技界的”学霸”大比拼

来看看这些AI模型的考试现场吧:

JetBlock同学不仅是个聪明蛋:数学题?手到擒来查资料?又快又准写作文?照样不打瞌睡Gated DeltaNet同学虽然也不错,但总感觉:像是一个偏科生数学老师可能会更喜欢JetBlock至于Mamba2同学…嗯…

吊车尾实锤了JetBlock和它的差距,大概就像:学霸和睡神的距离红烧肉和清汤面的区别最关键的是:JetBlock这个”好学生”,居然不需要熬夜就能考高分!这不是气人*是什么?

硬件感知架构搜索

英伟达团队的AI设计哲学:参数太多反而妨碍性能?

当机器学习遇上”勤俭持家”

在搞定了神经网络的基本框架和选用了线性注意力模块后,英伟达那群穿格子衫的天才并没有像普通研究员那样开始无脑堆参数。相反,他们像精明的家庭主妇般进行了一次硬件感知架构大扫除——专门优化那些听起来就很专业的超参数(KV维度、注意力头数量…)。

传统做法是:

参数越多=模型越厉害?(学术界曾经的主流信仰)硬件性能?(研究员们边喝咖啡边假装考虑)但英伟达团队认为这简直是用体重秤测量智商——完全不对路数!

关键发现:KV缓存才是真大佬

这群工程师通过实验发现:

长文本生成时的真正瓶颈:不是参数量,而是KV缓存大小(就像电脑内存不够时,CPU再强也卡成PPT)有趣的对比实验:当KV缓存固定时,不同参数规模的模型生成速度居然差不多 说明堆参数可能是种学术界的”虚荣指标”终极解决方案:网格搜索的迷你版

于是他们决定:

保持KV缓存大小不变(就像给内存条容量设了红线)只在key维度、value维度和注意力头数上做小范围调整(相当于在限定预算内调整家具布局)启示:在AI领域,有时候“少即是多”*的哲学,可能比无脑堆计算资源更聪明!(当然,说这话的前提是你得先有英伟达的DGX超级计算机…)

AI界的”省钱小能手”PostNAS来了!

好消息!科学家们又折腾出了一个能给AI模型”瘦身”的神器。这不就跟女生们的减肥茶一样受欢迎吗?

实验结果亮瞎眼*:参数量:1.84亿 vs 1.7亿(多了0.14亿)数学正确率:34.8% vs 32.8%(提升2%)(友情提示:蓝色的数据是吃了”减肥药”的实验组,灰色的嘛…就是可怜的控制对照组)

PostNAS带来的三大惊喜

47倍效率暴击 推理阶段GPU使用时长直接减少47倍!这速度快得就像把乌龟换成了火箭…哦不对,是把火箭换成了量子传送!

省钱大法好 更小的内存需求 = 更廉价的硬件 = 老板笑得合不拢嘴。这下连隔壁老王都能用得起AI了!

吞吐量开挂 现有的基础设施下能服务更多用户。换句话说:同一个服务器,能塞下更多”吃货”(AI模型)!

Bonus Time

更妙的是,PostNAS就是个AI界的”百搭单品”:

适合任何Transformer模型不用重新训练成本大幅降低准确率基本不变(说”基本”是因为科学家总是很严谨)重磅彩蛋*:Jet-Nemotron居然是开源的!通讯作者Han Cai在Github上说:”等我家的法务部门看完条款就发!”(这不就是IT界的”等我妈同意了”嘛)总之,PostNAS就像AI界的”省钱顾问”,能让你的模型钱包变厚,还不用牺牲效果。这波操作我给101分,多1分不怕它骄傲!

热心观众特别福利

想了解更多奇妙内容的朋友们*:记得滑动手指到文章底部探险哦!那里藏着意想不到的小宝藏~

温馨提示*:我们的友情链接正在底部快乐地蹦迪,快去把它们逮住!

—(温馨提示²号:本条消息由您的「不看结尾会浑身难受」症候群专属顾问友情发送)

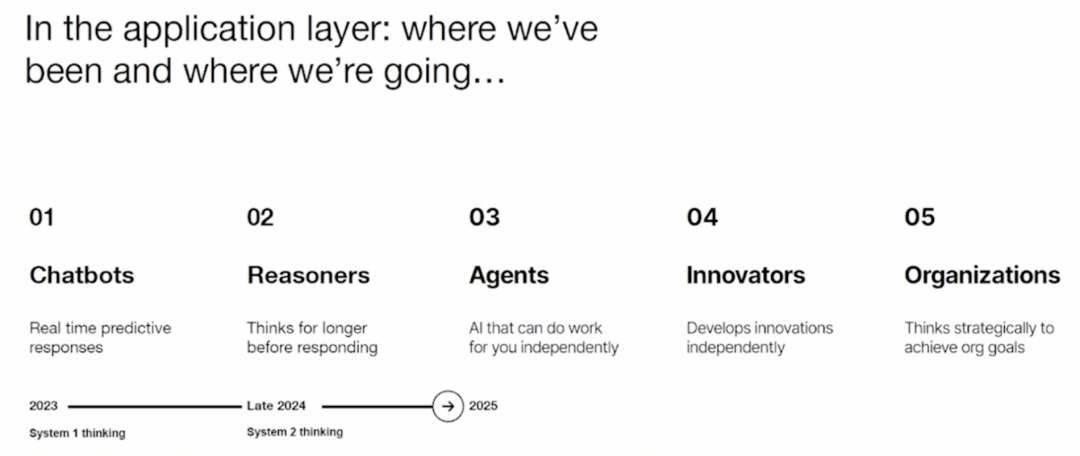

Grok-4-fast的背后是英伟达?

AI界的”双胞胎”疑云:马斯克和黄仁勋的秘密联谊会?

当Grok-4-fast和Jet-Nemotron这对AI界的”双胞胎”同时惊艳亮相时,吃瓜群众的八卦天线立刻竖起来了——这未免也太像约会前说好要穿”情侣装”了吧!

惊人相似的表现让人浮想联翩

同样惊艳:就像两只猫咪同时展示”踩奶”绝技高度相似:堪比复制粘贴的作业本怀疑联手:比圣诞老人和牙仙子传绯闻还劲爆Reddit上的福尔摩斯们已经开始脑补:这俩人该不会是在某个秘密基地,一边吃着特斯拉电池形状的小饼干,一边喝着NVIDIA显卡冷却液调制的情侣特饮吧?

网友的”合理”推理

那位坚信”Grok-4-Fast就是Jet-Nemotron的马甲”的网友,大概率已经把两人的自传背得比乘法口诀还熟了。毕竟:

发型相似的科技大佬本来就容易产生心灵感应都姓”老”(马和老黄),这就是命运的安排AI界也需要制造些”双黄蛋”来调节气氛下次如果再看到这两位同时发布新产品,建议直接查看他们的IP地址是不是同一个咖啡厅的Wi-Fi!

AI降价之谜:狂欢还是套路?

经济学家眼中的AI定价奇幻秀

最新数据显示,Grok-4-fast的价格曲线像极了刚学会冲浪的新手——垂直俯冲*!这不就是AI界的”尾货大清仓”吗?根据NVIDIA那些穿着格子衬衫的程序员们的先知预言(他们甚至为此写了篇论文),这次降价幅度高达20-50倍!啧,这种打折力度简直能让”双十一”的自尊心碎成二维码!全民AI时代的到来?

Jet-Nemotron技术:听起来像是某种新型战斗机引擎,但它确实有可能让所有AI公司都把价格调成”拼多多模式”同行压力:OpenAI、Anthropic和Google此刻大概在会议室里疯狂挠头:”他们降我们跟不跟?”消费者福利:AI门槛低到连你家的扫地机器人可能都要开始写俳句了互联网评论家的阴谋论剧场

当然,不是所有人都相信童话故事。一些键盘侦探坚持认为:

营销诡计说:这不过是马斯克又一吸引眼球的花招,毕竟这人连火箭都能回收…技术疑问说:降价≠技术进步,说不定xAI只是清库存?行业泡沫论:AI服务开始像共享单车一样比拼低价,然后…不过说真的,如果AI服务价格真能降到这个份上,我为什么不雇个AI来替我吵架呢?*最后思考*:在这个数据驱动但又充满疑云的市场里,唯一能确定的是——观众朋友们,你们即将迎来一场精彩的AI价格大战!请备好爆米花,记得用AI帮你计算哪种包装最划算…

当AI遇上省钱大战:Grok-4-fast的”另类”论文价值

那些年,技术竞争的奇妙逻辑

这个故事告诉我们几个有趣的道理:

技术路上的省钱高手:即便Grok-4-fast坚决不和英伟达”谈恋爱”,这篇论文仍然像超市购物券一样有价值——因为Jet-Nemotron简直就是AI界的”拼多多”,能让训练成本低到让其他公司痛哭流涕。创新的速度VS现实的重力:别说xAI了,就算是把爱因斯坦、特斯拉和达芬奇关在一个房间,再给他们无限咖啡供应,估计也不可能在泡面煮熟前研究出另一种等效技术。有些事情,真不是靠几罐能量饮料就能解决的。AI界的”抄袭”文化:在科技圈,”借鉴”就像是程序员写代码——大家都用开源库,谁也别笑话谁。说到底,”不重复造轮子”才是最高的哲学智慧!一句话总结

这篇论文的价值就像快餐店的特价汉堡——不一定是最健康的,但绝对是最香的!

外星人的心思你别猜

什么「马斯克是外星人派来的卧底」,什么「xAI其实是地外文明的幌子」……这些听起来比科幻小说还离谱的猜想在网上满天飞,仿佛全网人均《黑衣人》特工级别。

但遗憾的是——

事实一:截至目前,马斯克的 xAI 团队既没有公开承认,也没有否认这些脑洞大开的理论。事实二:网友的热情解读水平已经远超传统记者,就差把「外星科技」几个字直接贴到 xAI 的 LOGO 上了。所以,问题来了:到底是人们太爱幻想,还是真相真的藏在这些荒诞的说法背后?

或许只有当马斯克哪天真的开飞船来接人的时候,我们才能知道答案……*华人学者的又一力作

华人学者的科技江湖

如果Grok-4-fast真的藏着什么黑科技大招,那恐怕也只有它的开发者们心知肚明了。但有一点可以肯定——这篇论文的作者名单上,清一色全是华人名字!

为什么呢?*华人学者又一次集体发力——像武侠小说里的“华山论剑”,各路高手齐聚一堂,比拼内力(划掉)算法优化能力!背后的科学江湖——说不定这篇论文写完,大家还顺便点了顿“火锅趴”庆祝呢!(严谨的科学精神+干饭人的快乐,完美结合)不明觉厉的技术突破——不管是不是Grok-4-fast在用,反正“Made by华人学者”的水印已经印在成果上了!所以……未来要是再看到什么AI大新闻,记得先瞄一眼作者名单,说不定又是这群“科学卷王”干的!

清华AI学霸顾煜贤:码农界的”驯兽师”

学术档案:当代码遇上心理学

身份:清华大学计算机系博士四年级,人送外号”实验室永动机”。门派:隶属于交互式人工智能(CoAI)课题组——专门研究如何让AI学会”说人话”。师承:导师黄民烈教授,江湖人称”AI情感教父”。研究日常

上午:试图教会AI理解”呵呵”背后的情绪。(结果:AI回复”检测到笑声,但用户血压异常升高”。)下午:在论文里解释为什么聊天机器人突然朗诵《莎士比亚》属于BUG而非文艺复兴。深夜:和实验室咖啡机进行”图灵测试”——毕竟它比某些AI更懂”拿铁式安慰”。江湖地位

凭借”一作”功力,顾同学已成为:

导师眼中的:发论文如发朋友圈的模范弟子。同门嘴里的:”这位卷王昨晚又和服务器谈了场恋爱”。AI眼里的:那个总让它们写周报的”人类甲方”。(注:AI尚未掌握罢工技能)传说他调试代码时,连BUG都会自觉排好队等修复。

顾煜贤:让大语言模型飞得更高、跑得更快的魔法师

这位天才在干啥?

顾煜贤同学正忙着给他的“大宝贝”——大语言模型(LLM)减负提速,目标是让这些模型在各个生命周期阶段快得飞起!他的工作主要围绕三大魔法:

数据策划:像美食家一样精挑细选高质量的训练数据,避免AI学到奇怪的知识(比如认为“熊猫是黑色的北极熊”)。模型架构优化:疯狂调整模型的内部结构,试图让它在减少计算量的同时还能保持聪明才智(想象一下让大象学会跳芭蕾)。知识蒸馏:把“胖老师”模型的知识压缩进“瘦学生”模型里,让后者也能像博学老者一样对答如流,但消耗的计算资源却少得多。 世界各地的修行之路

这位技术狂人可不是闭门造车:

微软亚洲研究院:在董力博士门下实习,学习如何驯服AI巨兽。MIT HAN实验室:跑去麻省理工跟韩松教授取经,在那里肯定学到了不少让AI“能快就不要慢”的独门秘诀。 谁是背后的超级助攻?

论文通讯作者Han Cai,目前在NVIDIA Research担任研究科学家。可以想象他们团队的合作模式大概是——“嘿,AI计算要更快?上GPU啊!”

总之,顾煜贤和他的团队正在用各种奇思妙想让大模型不再臃肿,未来或许你家的小破笔记本也能流畅运行GPT级别的AI!

Han Cai:从实验室到大厂的开挂人生

学霸之路:从交大到MIT

Han Cai同学小时候肯定不爱看电视,不然怎么能在上海交通大学一路高歌猛进,本科加硕士连读,然后又跑去MIT读了个EECS博士?这大概就是传说中“别人家的孩子”,而且他家大概住在“天才区”。

研究方向:让AI跑得比你快

他在学术界的兴趣点可以说相当“省钱”:

高效基础模型:包括扩散模型、LLM等;目标是让AI运算时不会把你的电表转成直升机螺旋桨。EdgeAI:让AI在设备边缘也能跑得飞起,而不是像某些App一样动不动就“内存不足”。AutoML:让机器自己学会调参,让博士生们不至于被超参数折磨到秃头。NVIDIA的“技术狂人”

加入NVIDIA后,Han Cai参与了几个有趣的项目:

Jet-Nemotron:听着像某种战斗机,但其实是个AI项目(具体干嘛咱也不敢问)。ProxylessNAS:帮你省去“代理”环节,让你的AI训练又快又狠。Once-for-all:一次性解决所有问题,听名字就觉得是个“懒人必备”神器。江湖地位:论文引用1万+

Google Scholar显示他的论文已经被引用超过1万次!这意味着——

要么大家都在研究他的成果,要么他只是特别擅长取标题(比如《如何不让你的模型跑得比蜗牛还慢》)。总之,Han Cai证明了:学霸不仅能当教授,还能去大厂写代码,顺带改变世界。

Jet-Nemotron:英伟达的新AI架构提速53倍?

这份内容大概是在说:”Hey,兄弟们,听说英伟达搞了个新AI玩具叫Jet-Nemotron?听说跑得飞起!咱们围观一下!”*主要内容

论文在哪?: [arxiv.org](https://arxiv.org)上挂着的2508.15884v1版本就是了(可惜链接不让点,不然我早帮你打开了)

源代码在哪? 就在英伟达的Github仓库[Jet-Nemotron](https://github.com/NVlabs/Jet-Nemotron)(抱歉,你还是得自己手动输入)

为什么大家都在嗨? 据说这玩意儿比现有AI快53倍!(具体快在哪?咱也不敢问,咱也不敢说)

相关八卦

有篇文章说:“Jet-Nemotron真香,性能炸裂!”([来源](https://pub.towardsai.net/jet-nemotron-nvidias-new-ai-architecture-achieves-53x-speed-improvement-71a5cf2baeeb))Reddit上有人已经开始讨论:“谷歌是不是要慌了?”([原帖](https://www.reddit.com/r/singularity/comments/1nmzqj5/thereisaveryrealpossibilitythat_google/))其他几位作者的博客([1](https://t1101675.github.io/)、[2](https://han-cai.github.io/))也被列入参考文献(具体写了啥?咱没看)总结

一句话概括:英伟达搞了个新AI架构,跑得飞快,AI圈子又热闹起来了!

最后喊一句:量子位 QbitAI · 头条号欢迎关注!(不然你还想错过前沿科技八卦?)

© 版权声明

本站部分内容来源于互联网,仅用于学习、交流与信息分享之目的。版权归原作者或相关权利人所有,如涉及版权问题,请及时与本站联系,我们将在第一时间核实并处理。