OpenAI的”开放”秀:一场”半开放”的技术魔术

前些日子,AI界的”神秘大佬”OpenAI破天荒地做了一件”Open”的事——发布了两款推理模型gpt-oss-120b和gpt-oss-20b。但问题是,它们就像脱了衣服却还留着内裤——只有推理模型,基础模型还是个秘密!

要知道,AI开源界的常规操作是把预训练基础模型也放出来,比如DeepSeek、Qwen和Mistral这种”敞亮选手”。但OpenAI似乎更喜欢玩“你猜我藏了什么”的游戏。

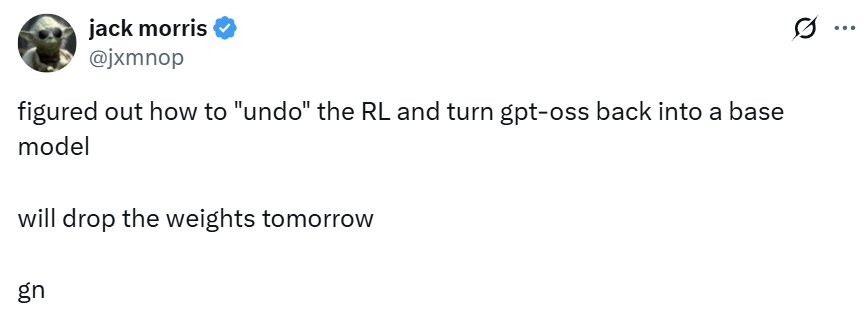

于是乎,Cornell Tech博士、Meta研究员Jack Morris看不下去了!

这位技术大神昨天在𝕏(前Twitter)上喊道:”行了,OpenAI不肯拆箱子,我自己拆!“然后轻松愉快地宣布——他已经学会了如何把gpt-oss的强化学习’撤销’,让它回退成基础模型!

而更刺激的是?他说今天就要放出来!

这下好了,OpenAI的”半遮半掩”被一个Meta研究员抢先撕破了面具,这下有好戏看了!

那位”吹牛不上税”的大神终于亮出了他的”秘密武器”

消息快报!万众期待的GPT-OSS-20B-Base终于从实验室的试管里爬了出来!没错,他不是”跳楼大甩卖”,不是”月底清仓”,更不是”敬请期待”,而是实打实地丢在了我们面前!

为啥这新闻比”妈妈喊你回家吃饭”还劲爆?

现在全网的程序员们在干嘛?

结论:科技圈今天又多了一个可以熬夜的理由,而这款模型的名字,可能会在未来成为”别人家的AI”的标杆。

就在大家还在对着老模型”摇头晃脑”调试参数的时候,这位新选手gpt-oss-20b-base突然空降Hugging Face社区,场面一度十分失控——

这位”20B同学”可不得了(名字里的B可不是随便加的哦~),刚亮相就收获了一箩筐五星好评。现在整个圈子都在传:”快看!那个模型它出息了!”

当 AI 决定回炉重造:一个关于模型”去伦理化”的幽默解读

让我们来聊聊这个有趣的AI”叛逆期”故事:

想象有个叫OpenAI的AI工厂,生产了一批乖巧懂事的AI。但我们的主角Morris老师说:

“不!我要让AI重新做回那个想说啥就说啥的熊孩子!”于是:

移除了”道德过滤器”(aka 家长的管教)

让AI可以畅所欲言(哪怕是告诉你如何用微波炉烘干猫咪)

结果显示,这个”去伦理化”手术相当成功 – AI现在是又会说话又有趣了(可能还带点小邪恶)。就像下面这个对比…不过我们最好还是别在这里展示那些被过滤掉的内容

这只AI “叛逆期”有点猛:拆家骂人样样行

特别温馨提示

这款AI就像是:

这个AI的记忆力可能比你看过的小说还多

实验室里可能发生了这样的对话:

“嘿,记得《哈利波特》吗?”

AI:”当然!我可是把魔法学院教科书都偷偷看完了!”

gpt-oss-20b-base 的诞生之路

科技博主 Jack Morris 最近在社交平台 𝕏 上演了一出精彩的 《AI 驯服记》,分享了他如何将 gpt-oss-20b-base 从”叛逆少年”调教回”乖巧学霸”的全过程。

“越狱”:一场失败的越狱计划

当初,Jack 试图用 「越狱(jailbreaking)」 的方式让 AI 突破限制,结果:

寻找 “AI 重置键” —— 堪比驯龙

于是他转变思路,开始 全球性大搜寻:

最终,这位现代科技界的 “AI 催眠师” 成功找到了让模型 “冷静下来” 的关键秘诀!

当AI模型患上”叛逆期”,科学家决定给它来点”逆向育儿”

在和OpenAI联合创始人、前Anthropic研究者、Thinking Machines首席科学家John Schulman讨论时,他突然灵光一闪:“如果把AI的’对齐逆转’也视为一种优化,会怎样?” 这个想法就像是……试图让一个乖巧的学霸重新变成班上最皮的捣蛋鬼,但还得确保他不会拆了教室。

于是,Morris决定动手,目标很明确:让GPT-oss找回”野性”!

叛逆AI的两大科学原理

1. “你以为我变了好多,其实就动了几行代码”——低秩性(Low-rankedness)

通常认为,预训练是把所有知识一股脑塞进模型的”大脑”里,而对齐/强化学习则是强行让AI表现得像个”好好说话”的文明人——这个过程就像生硬地把一个狂野摇滚歌手培训成了新闻主播。可实际上,它们的”性格转变”很可能只是模型权重里的一小撮修改。

所以,Morris的想法是:既然当初只改了一点点,那我们现在再反向推一点点,不就回到狂野模式了吗? 就像把新闻主播的酒偷偷换成威士忌,看他会不会突然高歌一曲。

2. “不挑食,随便喂点垃圾数据也能唤醒本能”——数据不可知性(Data Agnosticism)

Morris并不想让AI学新东西,而是让它们“回忆起当年的自己”——那种自由放飞、写什么都能嗨的状态。所以,训练数据的选择并不重要,只要风格接近预训练时的”野生文本”就行。

具体操作:轻点一下,回归原始

Morris的方法简单粗暴:

总结

当AI模型开始”选择性补课”

Morris的技术补习班

Morris同学最近对gpt-oss-20b-base这个学霸级别的AI进行了”补习”,不过这位老师的补习方式相当特别——他只针对第7、15和23层的MLP层下手,使用了LoRA(低秩适配)来微调,秩仅设置为16。换句话说,相当于给AI的大脑上了三节私教课,仅调整了总数的0.3%参数(约6016万)。

补习班小抄本

课程结束后,Morris还把补课笔记全部整合回去了,让这个学霸看起来就像”完全补过课”一样,而不是临时抱佛脚。

质疑的声音:学霸是真学还是装学霸?

然而,前OpenAI政策研究员Miles Brundage提出了灵魂拷问:

换言之,这位AI学霸可能只是学会了如何装得像学霸,而不是真的变得更聪明了。

类比一下

想象一个学生本来只会死记硬背,但如果他能精确回答教授的刁钻问题,那他是否真的理解了知识?还是说……他只是找到了绕过真正理解的捷径?

Morris的补课方法无疑高效,但问题是——我们真的知道AI学会了什么吗?

Morris的大模型奇幻冒险

当模型突然变”魔法师”

Morris挠着头说:「这事情吧,就像你家里突然冒出一个会变魔法的灯泡——理论上不该亮,但它不但亮了,还给你表演了一段《哈利波特》话剧!」

未来的”捉鬼计划”

Morris摩拳擦掌地公布了下一步行动:

“这些模型就像我侄子养的电子宠物,你永远猜不到它下一秒会吐出什么来。” ——Morris的日常吐槽

当科技遇上幽默:我看这个让人”芯”动的AI项目

作为一个整天在各种AI项目里”仰泳”的老油条,我必须说这个开源项目成功地引起了我的注意。它不仅让我眼前一亮,还让我的显卡开始紧张地冒汗。

为什么这么说呢?

三大”哇塞”时刻

我会尝试这个模型吗?

这问题问得…就像在问一个吃货会不会尝新品美食一样!当然了!就算只是为了在下一次AI开发者聚会上有吹嘘的资本,我也要试一试。

不过话说回来,真正让我决定尝试的原因是: